記事の内容を音声で聞きたい方はこちら↓

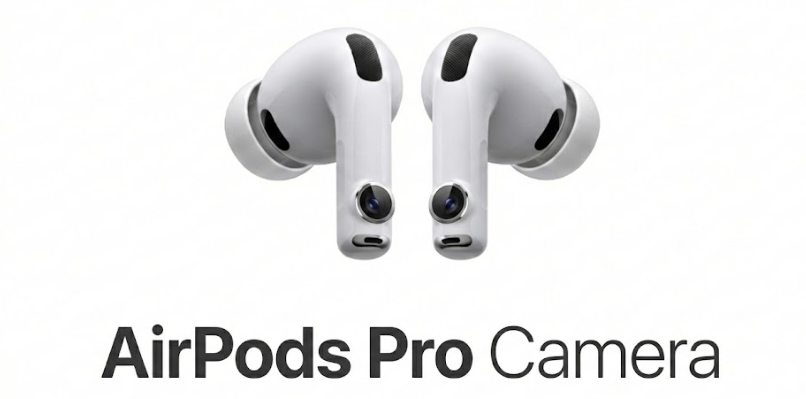

イヤホンは単に「音を聴くデバイス」から、周囲を理解する「センサー」へと進化しようとしている。Appleの次期AirPods Proに、カメラや赤外線(IR)センサーが搭載されるというリーク情報が駆け巡っている。これが事実なら、単なるノイズキャンセリング性能の向上といった次元の話ではない。

情報の核心は、次期モデルが空間認識能力を持つという点だ。具体的には、スマートIRセンサー、あるいは小型カメラの搭載が有力視されている。これまでアナリストのミンチー・クオ氏も赤外線コンポーネントの採用を示唆しており、情報の確度は決して低くない。このカメラ搭載の噂はかなり前から言われていたが、またここにきて再熱してきた感じだ。

そもそも、なぜイヤホンに視覚的なセンサーが必要なのか。最大のメリットは、ユーザーがスマホの画面を見ずに環境情報を得られる点にある。例えば、ジェスチャー操作の精度向上はもちろん、歩行中のナビゲーション支援や、混雑した場所での衝突警告など、現実世界のアシスト機能が想定される。

また、オーディオ体験においても、壁や障害物との距離をリアルタイムで計測し、再生音を環境に合わせて最適化する高度な空間オーディオが実現するはずだ。

技術的な焦点は「カメラか、IRか」という点に絞られる。プライバシーへの懸念やバッテリー持続時間を考慮すれば、完全なカメラよりも深度検出に優れた赤外線センサーの方が現実解に近い。消費電力を抑えつつ、必要な空間データだけを取得するアプローチだ。

さらに驚くべきは、この大幅な機能追加がありながら「価格据え置き」の可能性があるという情報だ。高効率な自社製チップとソフトウェア統合の妙技といえるが、これが実現すれば競合他社にとっては悪夢でしかない。ソニーやBoseが音質競争にしのぎを削る中、Appleが「空間認識」という別軸の価値を同価格帯でぶつけてくれば、シェア構造はさらにApple一強へと傾く恐れがある。

Appleの狙いは明確だ。Vision Proのようなヘッドセットはまだ一般的ではないが、AirPodsならすでに数億人が耳にしている。そこにセンサーを載せることで、誰もが意識せずに「空間コンピューティング」の入り口に立つことになる。

次期AirPods Proがいつ市場に投入されるかは不透明だが、方向性は定まった。音質だけの競争は終わりを告げ、今後は「いかに現実世界を認識し、ユーザーをサポートできるか」が問われることになる。オーディオ機器という枠組みを超え、真のウェアラブルデバイスへと脱皮する瞬間が近づいている。