ふと気づけば、私たちの日常はAI(人工知能)技術と深く結びついています。スマートフォンの音声アシスタントから、ネットショッピングのレコメンド機能、さらには日々のニュースフィードの最適化に至るまで、AIは目に見えない形で私たちの生活を豊かに、そして便利にしてくれています。

そんな中、Googleが開発した最先端の軽量AIモデル「Gemini Nano」が、いよいよ私たちの愛用するAndroidアプリの世界を、根底から変えようとしています。

これまでは一部の高性能なスマートフォン、例えばGoogle自身のPixelシリーズや、Samsung、Motorola、Xiaomiの選ばれた最新機種でのみその恩恵を享受できていたGemini Nano。

しかし、間もなく開催されるGoogleの開発者向け一大イベント「Google I/O 2025」を目前に控え、このパワフルなAIが、あらゆるサードパーティ製アプリへとその扉を開く可能性が急浮上してきました。これは、単に新しい機能が追加されるという話ではありません。私たちのスマートフォン体験が、よりパーソナルで、より直感的で、そして何よりも「賢く」なる未来への大きな一歩を意味するのです。

Gemini Nanoとは何か?そして、なぜ今、注目されるのか

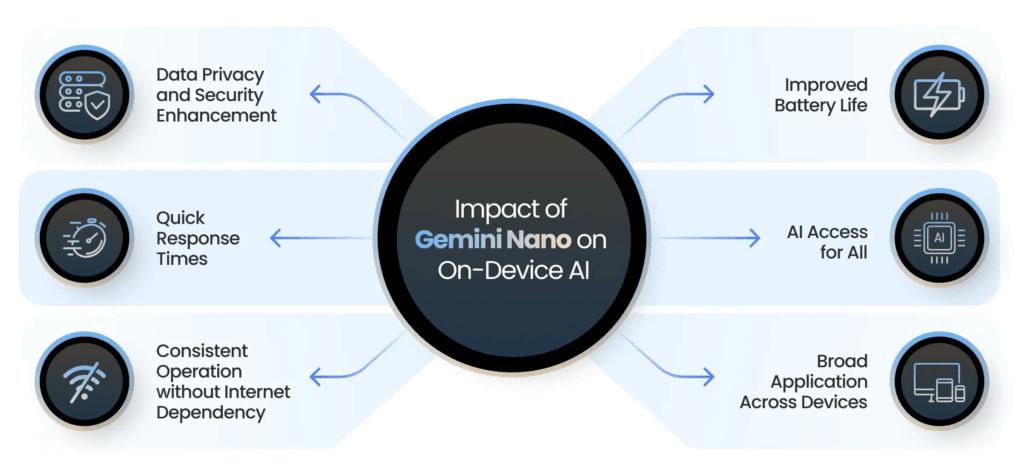

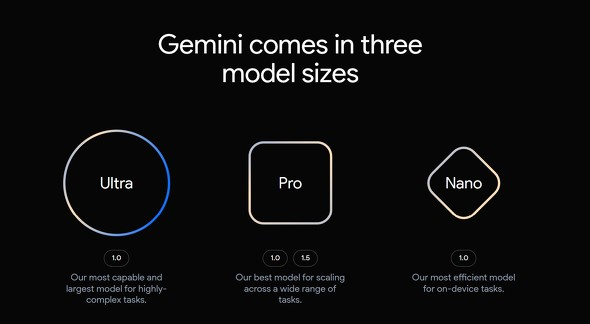

まず、Gemini Nanoについて簡単におさらいしておきましょう。Gemini Nanoは、Googleが開発した大規模言語モデル「Gemini」ファミリーの中で、特にオンデバイスAI、つまりインターネット接続なしにスマートフォン本体で動作するように設計された、最も軽量かつ効率的なモデルです。

これにより、ユーザーのプライバシーを保護しながら、リアルタイムに近い速度でAI処理を行うことが可能になります。これまで、このGemini Nanoの恩恵は、前述の通り、Google Pixelシリーズなどの一部のハイエンドデバイスに限られていました。これは、AIモデルをスムーズに動かすための高度な処理能力や、専用のハードウェアサポートが必要だったためです。

しかし、Googleはこの状況を変えようとしています。その鍵となるのが、開発者向けのツールキット「ML Kit」に追加される新しい「GenAI API」の存在です。

Android Authorityが報じたところによると、Googleはすでに関連ドキュメントを公開しており、この新しいAPIがGemini Nanoのパワーをサードパーティ開発者にもたらすことが示唆されています。これは、これまで限られたユーザーしか体験できなかった高度なAI機能が、私たちが日常的に使うさまざまなアプリに組み込まれる可能性を意味し、大きな注目を集めているのです。

Google I/O 2025で明かされる未来 – GenAI APIが切り拓くアプリの新境地

Googleが毎年開催する開発者向けカンファレンス「Google I/O」は、同社の最新技術や将来のビジョンが発表される場として、世界中から熱い視線が注がれます。そして、まもなく開催される「Google I/O 2025」では、このML Kitに追加される新しいGenAI APIに関するセッションが予定されており、その全貌が明らかになることが期待されています。

このGenAI APIは、開発者にとって、複雑なAIの専門知識がなくとも、Gemini Nanoのような高度なAI機能を自分たちのアプリに容易に組み込むことを可能にするものです。Googleのドキュメントによれば、このAPIは「Gemini Nanoのパワーを活用し、簡素化された高水準インターフェースを通じて、一般的なタスクをすぐに実行できるパフォーマンスを提供します」と説明されています。

つまり、アプリ開発者は、より少ない労力で、よりインテリジェントなアプリを開発できるようになるのです。

この動きは、Androidエコシステム全体にとって大きな前進と言えるでしょう。Gemini Nanoがより多くのデバイス、より多くのアプリで利用可能になることで、ユーザーはメーカーや機種の垣根を越えて、AIによる恩恵を享受できるようになります。これまで「AI搭載スマートフォン」という言葉は、どこか特別な響きを持っていましたが、近い将来、それはごく当たり前の機能として、私たちの生活に溶け込んでいくことになるのかもしれません。

あなたのアプリはこう変わる!Gemini Nanoがもたらす具体的な機能例

では、この新しいGenAI APIを通じて、私たちの愛用するアプリは具体的にどのように進化するのでしょうか?Googleが公開したドキュメントからは、いくつかの魅力的な機能が浮かび上がってきます。

例えば、私たちが日常的に使うチャットアプリを考えてみましょう。短いメッセージを送信する前に、Gemini Nanoが文法的な誤りや不自然な表現を指摘し、校正してくれるようになるかもしれません。さらに、同じ内容のメッセージでも、フォーマルなトーン、親しみやすいトーン、あるいはユーモラスなトーンなど、状況に合わせて異なるスタイルに書き換えてくれる機能も期待できます。これにより、コミュニケーションはよりスムーズに、そしてより表現豊かになるでしょう。

また、情報収集の効率も格段に向上する可能性があります。長文の記事やレポートを読む時間がないとき、アプリがその内容を瞬時に要約し、重要なポイントだけを提示してくれる機能が実現するかもしれません。これにより、忙しい現代人でも、効率的に情報をキャッチアップできるようになるでしょう。

さらに興味深いのは、画像に関する機能です。アプリに画像をアップロードするだけで、Gemini Nanoがその画像の内容を簡潔に説明してくれる機能が提供されるかもしれません。これは、視覚障碍を持つユーザーのアクセシビリティ向上に貢献するだけでなく、写真管理アプリでの自動タグ付けや、ソーシャルメディアへの投稿文案作成など、さまざまな応用が考えられます。

注意点も理解しておく – Pixelでの体験との違いとは?

このように、Gemini Nanoのサードパーティアプリへの展開は、私たちユーザーにとって非常に喜ばしいニュースです。しかし、一点、心に留めておくべきことがあります。

それは、これらの機能が、Google Pixelデバイス上でGeminiアプリを直接使用する体験と、必ずしも完全に同じではない可能性があるという点です。

サードパーティアプリに提供されるGenAI APIは、Gemini Nanoの持つ全ての機能へのアクセスを許可するものではないかもしれません。開発の容易さやパフォーマンスの最適化、あるいはセキュリティ上の理由から、利用できる機能が一部に限定されたり、カスタマイズされた形で提供されたりする可能性が考えられます。

とはいえ、このことは決して悲観的に捉える必要はありません。たとえ一部の機能であっても、それが広く多くのアプリで利用可能になることの意義は非常に大きいと言えます。

これまでAI機能とは無縁だったアプリが、よりインテリジェントな振る舞いを見せるようになるだけでも、ユーザー体験は格段に向上するはずです。そして何よりも、ユーザーがAIの恩恵を受けるための選択肢が大幅に増えることは、間違いなく歓迎すべき進展です。

AIが日常に溶け込む未来へ – ユーザーと開発者にもたらされるもの

Gemini Nanoのサードパーティアプリへの扉が開かれることは、単に技術的な進歩というだけでなく、私たちのスマートフォンとの関わり方、そしてAndroidエコシステム全体の未来に大きな影響を与えるでしょう。

ユーザーにとっては、これまで以上にパーソナライズされ、直感的で、そして「賢い」アプリ体験が当たり前になる時代が到来します。日々のコミュニケーション、情報収集、クリエイティブな作業など、あらゆる場面でAIのアシストを受けられるようになり、生活の質そのものが向上する可能性を秘めています。

一方、アプリ開発者にとっては、創造性を発揮し、ユーザーに新たな価値を提供するための強力なツールを手に入れることを意味します。複雑なAIモデルを一から開発する必要なく、最先端のAI機能をアプリに組み込めるようになることで、小規模な開発チームや個人開発者であっても、革新的なアイデアを形にしやすくなるでしょう。これにより、アプリ市場はさらに活性化し、多様性に富んだ魅力的なアプリが次々と登場することが期待されます。

Gemini Nanoのサポートが広がることで、これまでAI機能の恩恵を受けられなかった比較的低スペックなデバイスのユーザーにも、その扉が開かれるかもしれません。これは、デジタルデバイドの解消という観点からも非常に重要な意味を持ちます。

まとめ

Google I/O 2025で発表されると目されるGemini Nanoのサードパーティアプリへの対応は、私たちのスマートフォンライフに革命をもたらす、まさに「ゲームチェンジャー」と言えるでしょう。それは、単なる機能追加ではなく、AIがより身近な存在となり、私たちの日常に深く溶け込んでいく未来への序章です。

もちろん、その全貌が明らかになるのはこれからであり、実際にどのような形で私たちの手元に届くのかは、Googleの正式な発表を待つ必要があります。しかし、示唆されている情報だけでも、期待は膨らむばかりです。なにより、サードパーティー性のアプリとの連携が、円滑に行えるようになれば、Geminiの活用用途が大幅に広がる事は間違いないでしょう!

もし仮に些細な連携であっても、AI覇権を狙っているGoogleとしては、今後広がって行くことは間違い無いと予想されますので、長い目で見ることが必要でしょうね。