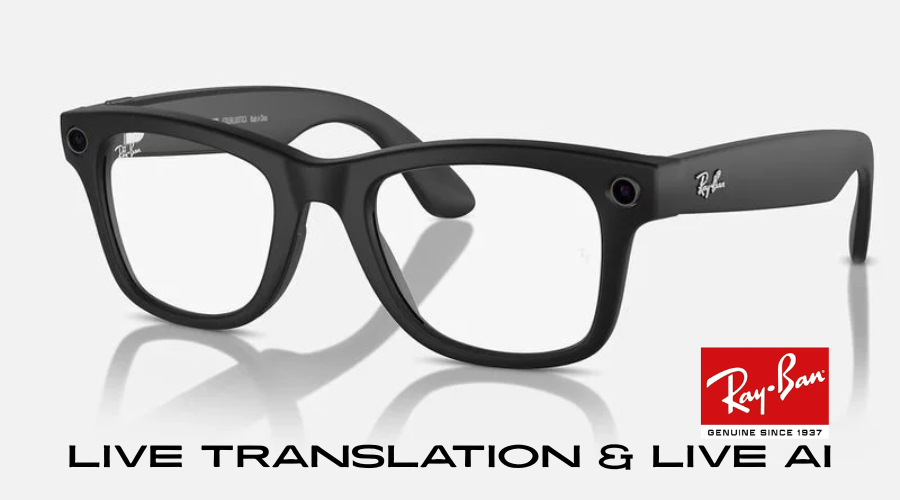

Metaが、Ray-Ban Metaスマートグラスの全ユーザーに向けて、画期的なライブ翻訳機能と、未来を先取りするライブAI機能を間もなく展開することを発表しました。これは、単なるスマートグラスの進化に留まらず、私たちのコミュニケーションや情報との関わり方を根底から変える可能性を秘めた、まさにゲームチェンジャーとなるでしょう。

Source:Meta

これまで一部のベータ版早期アクセスユーザーのみが体験できた、驚異のライブ翻訳機能が、いよいよRay-Ban Metaスマートグラスの全ユーザーに開放されます。Metaの発表によれば、この革新的な機能により、英語、フランス語、イタリア語、スペイン語を話す人々との会話が、まるで母語を話しているかのようにスムーズに行えるようになります。特別な設定は不要。「Hey Meta、ライブ翻訳を開始」と話しかけるだけで、グラスを通して相手の言葉があなたの選択した言語でリアルタイムに聞こえ、同時に、あなたの話した内容は相手のスマートフォン画面に翻訳されたテキストとして表示されるのです。

さらに驚くべきことに、Metaは近い将来、このスマートグラスに「ライブAI」という、SF映画さながらの機能を導入する予定です。ライブAIが実現すれば、Ray-Ban Metaスマートグラスの内蔵カメラを通して着用者が見るもの全てを認識し、それに関するリアルタイムなAIとの対話が可能になります。まるで、常に知識豊富なアシスタントが目の前にいるかのような体験が、ハンズフリーで実現するのです。

Meta社によると、このライブAI機能は、料理の準備中にレシピについて質問したり、ガーデニング中に植物の種類や手入れ方法を尋ねたり、あるいは見知らぬ場所を探索中に目の前の建造物や風景について情報を得たりするなど、様々なハンズフリーの状況で驚くほどの利便性をもたらします。特筆すべきは、ウェイクワードを毎回言う必要がない点です。一度会話を開始すれば、AIはリクエスト間の文脈を理解し、過去の質問を参照しながら、より自然でスムーズな対話が可能になるのです。

このMeta Ray-Banスマートグラスの進化は、Appleユーザーにとっても決して他人事ではありません。なぜなら、これは、Appleが将来的に目指すであろうスマートグラスの姿を垣間見せてくれるものだからです。

噂によれば、AppleもMetaのRay-Banのようなスマートグラスの開発を検討しており、AI、マイク、カメラといった機能を搭載する可能性があるとされています。ただし、現時点での情報では、Appleのスマートグラスには拡張現実(AR)機能は搭載されない見込みであり、Metaのスマートグラスとは異なるアプローチを取る可能性も示唆されています。

当然ながら日本語対応は未定です!(キリッ

ライブ翻訳機能の詳細

Meta Ray-Banスマートグラスに搭載されるライブ翻訳機能は、言語の壁を打ち破り、グローバルなコミュニケーションをより身近なものにする画期的な機能です。現在、対応している言語は、英語、フランス語、イタリア語、スペイン語の主要4言語であり、今後さらに多くの言語が追加されることが期待されます。

このライブ翻訳機能の最大の特徴の一つは、特定の言語パックを事前にダウンロードしておけば、Wi-Fiや携帯電話の接続がなくても利用できる点です。これは、海外旅行中や、電波状況が不安定な場所でも、リアルタイムな翻訳が可能になるという大きなメリットをもたらします。従来の翻訳アプリのように、都度インターネット接続が必要だったり、翻訳に時間がかかったりする煩わしさから解放され、よりスムーズで自然な会話体験が実現します。

実際の利用シーンを想像してみましょう。例えば、あなたがフランスを旅行中に、現地のパン屋さんでパンについて尋ねたいとします。「Hey Meta、ライブ翻訳を開始」と話しかければ、あなたの話した日本語(あるいは英語など、設定した言語)はフランス語に翻訳され、相手のスマートフォンの画面にテキストで表示されます。そして、パン屋の店員がフランス語で答えた内容は、あなたのRay-Ban Metaスマートグラスを通して、あなたの設定した言語(例えば日本語)でリアルタイムに聞こえてくるのです。まるで、通訳が常に隣にいてくれるかのような、シームレスな会話体験が実現します。

この機能のユーザー体験は、極めて直感的でシンプルです。複雑な操作や設定はほとんど必要なく、音声コマンド一つで簡単に起動できます。会話の流れを妨げることなく、リアルタイムに翻訳が行われるため、コミュニケーションの自然さを損なうこともありません。相手の言語が分からなくても、臆することなく積極的に会話に参加できるようになり、異文化を持つ人々との交流がより豊かで実り多いものになるでしょう。

Metaは、このライブ翻訳機能を通じて、言語の障壁を取り払い、人々がより সহজে に繋がり、理解し合える世界を目指していると言えるでしょう。今後の対応言語の拡大や、翻訳精度の向上にも期待が高まります。

リアルタイム認識、文脈理解、ハンズフリーの利便性

Metaが近い将来に導入を予定しているライブAI機能は、スマートグラスの可能性をさらに大きく広げる、まさに未来志向のテクノロジーです。この機能が実現すれば、Ray-Ban Metaスマートグラスは、単なる情報表示デバイスから、リアルタイムなAIアシスタントへと進化を遂げます。

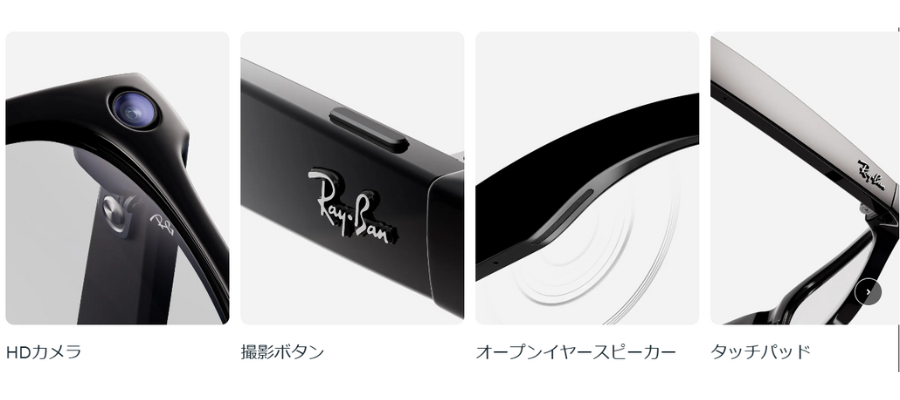

ライブAIの核となるのは、スマートグラスに内蔵された高性能カメラによるリアルタイムな物体認識能力です。着用者の視界に入るあらゆるものをAIが瞬時に認識し、その情報に基づいて、様々な質問に答えることができます。例えば、目の前に置かれた料理の種類やカロリー、道端で見かけた花の名前や特徴、あるいは博物館に展示されている美術品の解説など、知りたい情報をその場でハンズフリーで得ることができるようになります。

さらに、このライブAIの特筆すべき点は、会話の文脈を理解し、過去の質問を参照できることです。従来の音声アシスタントのように、毎回ウェイクワードを言う必要はなく、連続した自然な対話が可能です。例えば、「これは何という花ですか?」と尋ねた後、「手入れの方法を教えて」と続けるだけで、AIはそれが先ほど質問した花のことであると理解し、適切な情報を提供してくれます。まるで、人間同士の会話のように、スムーズでインテリジェントなやり取りが実現するのです。

このライブAI機能がもたらす利便性は、日常生活の様々な場面で計り知れません。料理中、手が汚れている時でも、レシピの次のステップを音声で確認したり、材料について質問したりすることができます。ガーデニング中には、植物の病気や害虫について尋ねたり、肥料の種類や与え方についてアドバイスを得たりすることができます。旅行中には、目の前の建造物の歴史的背景や、周辺のおすすめスポットについて尋ねたりすることも可能です。

ライブAIは、単に情報を提供するだけでなく、着用者の行動をサポートするインテリジェントなアシスタントとしての役割を果たすことが期待されます。ハンズフリーで、視覚的な情報をリアルタイムに理解し、自然な対話を通じてサポートを提供するこの機能は、私たちの生活をよりスマートで効率的なものに変えてくれるでしょう。

AR非搭載の可能性とMetaとの差別化

Meta Ray-Banスマートグラスのライブ翻訳とライブAI機能の登場は、Appleをはじめとする競合他社のスマートグラス戦略に大きな影響を与える可能性があります。特に、噂されているAppleのスマートグラスは、現時点では拡張現実(AR)機能を搭載しない見込みであるとされており、Metaの製品とは異なるアプローチを取る可能性が示唆されています。

もしAppleのスマートグラスがAR機能を搭載しない場合、その主な用途は、通知の表示、情報へのアクセス、そしてAIアシスタントとの連携といった、比較的シンプルな機能に限定される可能性があります。一方、MetaのRay-Banスマートグラスは、ライブ翻訳やライブAIといった、よりインタラクティブで実用的な機能を搭載することで、独自の強みを打ち出そうとしています。

Appleは、その強力なブランド力とエコシステム、そして洗練されたデザインによって、独自のユーザー体験を提供することを目指すでしょう。例えば、Apple Watchとの連携を強化したり、Siriとの統合を深めたりすることで、iPhoneユーザーにとって魅力的な選択肢となる可能性があります。プライバシー保護に対する意識の高さも、Appleの製品開発における重要な要素となるでしょう。

しかし、Metaのライブ翻訳やライブAIのような、革新的な機能は、Appleのスマートグラスが提供できない独自の価値を生み出す可能性があります。特に、言語の壁を取り払うライブ翻訳機能や、リアルタイムな視覚情報認識と対話を実現するライブAI機能は、日常生活における実用性が非常に高く、多くのユーザーにとって魅力的なポイントとなるでしょう。

Appleが今後、AR機能を搭載しないスマートグラスにどのような独自の価値を付加していくのか、そしてMetaのような実用的なAI機能をどのように取り入れていくのかは、今後のスマートグラス市場の動向を左右する重要な要素となります。両社の戦略の違いは、スマートグラスの未来の方向性を示す上で、非常に興味深い比較対象となるでしょう。

消費者への影響と未来の可能性

Meta Ray-Banスマートグラスに搭載されるライブ翻訳とライブAI機能は、消費者にとってどのような影響をもたらし、私たちの未来にどのような可能性を秘めているのでしょうか。

まず、コミュニケーションの面では、ライブ翻訳機能によって、言語の壁が劇的に低くなり、世界中の人々とより意思疎通を図ることができるようになります。海外旅行がより快適になり、国際的なビジネスシーンでのコミュニケーションも円滑になるでしょう。また、異なる文化を持つ人々との交流が促進され、相互理解が深まることで、より多様性を受け入れる社会の実現に貢献する可能性も秘めています。

学習の面では、ライブAI機能が、まるでパーソナルな知識エンジンとして機能し、私たちの知的好奇心を刺激し、学びを深めるための強力なツールとなるでしょう。目の前の物体や現象について、瞬時に情報を得たり、関連する知識を深掘りしたりすることが、ハンズフリーで簡単に行えるようになります。これは、学校教育や自己学習のあり方を大きく変える可能性を秘めています。

日常生活においては、ライブAI機能が、私たちの生活をよりスマートで効率的なものにするでしょう。料理、買い物、移動、仕事など、様々なシーンでAIがリアルタイムにサポートを提供し、私たちの意思決定を助け、タスクをよりスムーズにこなすことを可能にします。ハンズフリーであるという点は、両手が塞がっている状況でも情報にアクセスできるという大きな利便性をもたらします。

将来的には、これらの機能がさらに進化し、例えば、AR機能と統合されることで、現実世界に翻訳されたテキストやAIによる情報が重ねて表示されるといった、より高度な体験が可能になるかもしれません。また、個人の興味や学習履歴に基づいて、AIがよりパーソナライズされた情報を提供したり、能動的にサポートを提案したりするようになることも考えられます。

Meta Ray-Banスマートグラスのライブ翻訳とライブAI機能は、私たちのコミュニケーション、学習、そして日常生活のあらゆる側面において、大きな変革をもたらす可能性を秘めています。これは、単なるガジェットの進化ではなく、私たちの未来の生き方を形作る、重要な一歩となるかもしれません。